由于作者水平有限,文档中难免有些问题。如果你发现了问题或者有更好的建议,非常感谢你向我提出!如果有时间,我一定会及时在评论区修改哒~

Stable Diffusion是一款功能异常强大的AI图片生成器。它不仅支持生成图片,使用各种各样的模型来达到你想要的效果,还能训练你自己的专属模型。

WebUI使得Stable Diffusion有了一个更直观的用户界面,更适合新手用户。

但是,国内复杂的网络环境使得Stable Diffusion的安装变得比较麻烦,下载模型与调试问题也会比较费事。网上的信息也比较零散,在此做一个统一的整理。

备注:我使用的是Windows环境(Powershell),Linux命令与Powershell命令大致相仿,如果有特殊的地方,我会单独作说明。

现存的问题

备注:后续若还有未解决的问题,我会列在此处。

Stable Diffusion2.0(或2.1)由于是刚发布的版本,其专属模型在国内还没有快速下载地址,但可以通过加速器(如迅雷、Aria2Ng等)获得较快的下载速度。如果有网友放出了国内的镜像地址,我会尽快放出。

注意事项

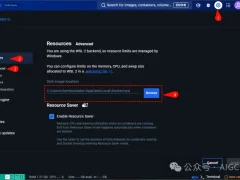

运行Stable Diffusion需要消耗较大的资源,对显卡的要求尤其高(至少4GB的VRAM)。所以,如果你没有较好的硬件资源,你可能需要在百度飞桨或Kaggle这些网站上搭建服务器以获得免费的硬件资源。

误区:很多网上的资料里的安装方法里都写了需要安装Torch、Anconda等其它程序,其实并不需要,不要把其它版本的Stable Diffusion和AUTOMATIC1111的Fork混为一谈,安装这些不必要的程序。这将节省不少步骤。

Step1:安装需要的程序Git

首先,我们需要安装Git。对于我们下一步的克隆来说,这是一个必不可少的工具。在Windows下,安装地址在这里:

https://registry.npmmirror.com/-/binary/git-for-windows/v2.38.1.windows.1/Git-2.38.1-64-bit.exe

(实际Git版本并不影响使用,这里使用的是Git 2.38)下载之后安装。Linux则需要用到软件包管理工具(因发行版而异)。我拿Ubuntu举例:

# apt install git

Python 3.10

然后,我们需要安装Python 3.10。这是官方文档上指定的版本,Windows下安装地址在这里:

https://mirrors.huaweicloud.com/python/3.10.8/python-3.10.8-amd64.exe

由于Linux不同的发行版默认软件包版本不同,不保证一定是3.10,故需自行下载编译。

Nvidia CUDA(按需)

注意:CUDA需要搭配Nvidia显卡驱动进行安装和使用。如果你使用的是AMD显卡,则需要使用Ort。详细安装及搭建方法请自行搜索。

如果你使用的是Nvidia显卡,则需安装CUDA。这是几乎所有的AI在Nvidia显卡上都需要的东西。Windows下,在这里(版本11.7.1,搭配Nvidia驱动516.94)进行下载安装:

Linux请在这里选择适合你的发行版的版本安装:

https://developer.nvidia.com/cuda-11-7-1-download-archive?target_os=Linux

在Windows下,安装CUDA一般只用根据安装程序的提示就可以安装了。但如果你不想安装太多冗余的东西,则可以只在安装选项中勾选Runtime和Development。

如果以上程序都已安装完毕,就可进入下一步啦~

Step2:克隆Stable Diffusion+WebUI

首先,检查磁盘的剩余空间(一个完整的Stable Diffusion大概需要占用30~40GB的剩余空间),然后进到你选好的磁盘或目录下(我选用的是Windows下的D盘,你也可以按需进入你想克隆的位置进行克隆。):

cd D: \\此处亦可输入你想要克隆的地址

然后使用Git克隆AUTOMATIC1111的stable-diffusion-webui(这里我是用了Ghproxy在国内进行加速):

git clone https://ghproxy.com/github.com/AUTOMATIC1111/stable-diffusion-webui.git

克隆完成后,进入到克隆好的目录。

cd .\stable-diffusion-webui

Step3:解决“疑难杂症”

在国外,安装Stable Diffusion比较简单,但是由于国内的网络环境,安装过程中可能会遇上不少麻烦。

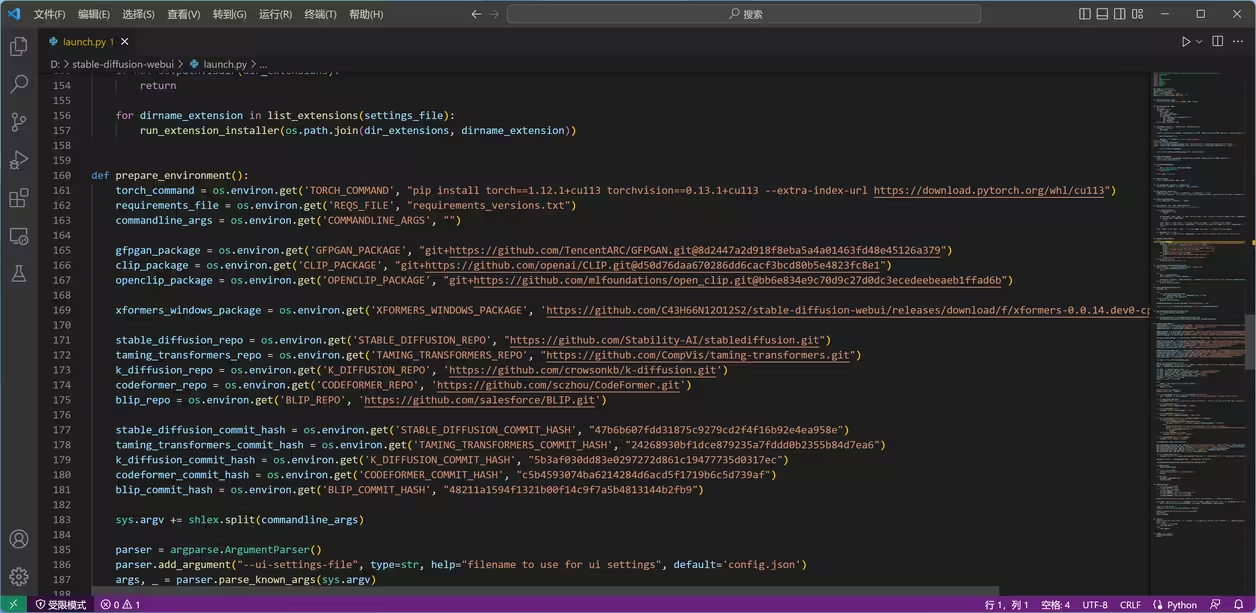

编辑“launch.py”(此处我是用的是Visual Studio Code,Linux则需要用到特定的文本编辑器)。

code .\launch.py

替换前

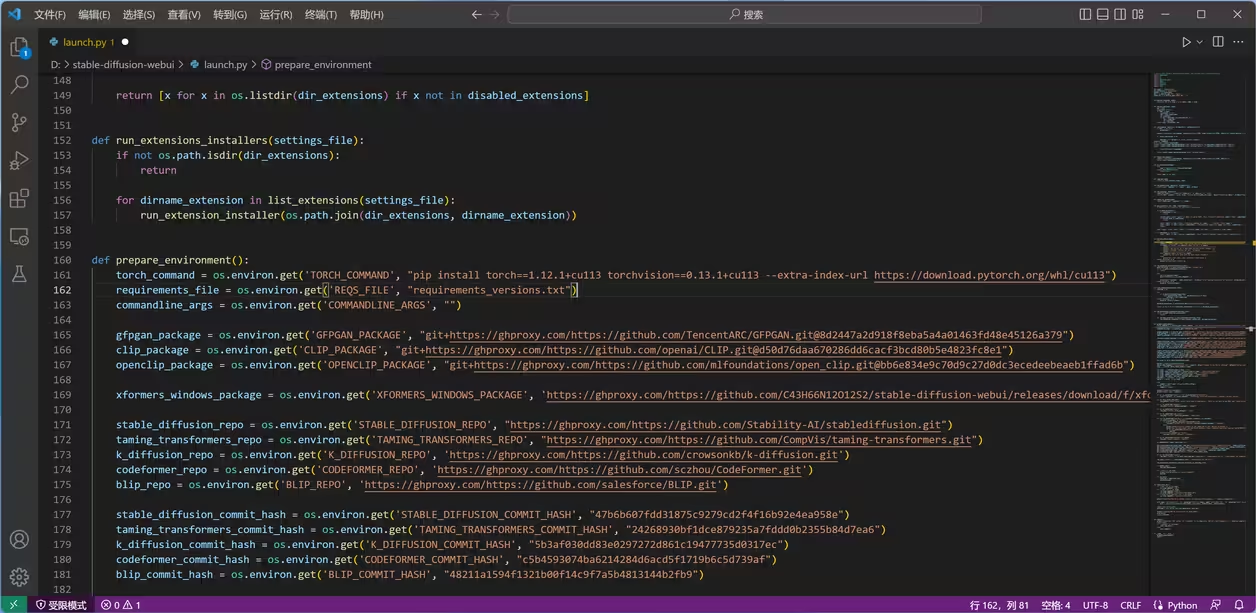

替换所有的“https://github.com”为“https://ghproxy.com/https://github.com”。这里也是利用Ghproxy进行代理,加速国内Git。

注意:不要使用“全部替换”!当Code把所有的“https://github.com”替换过一遍后,不必把“https://ghproxy.com”后面的“https://github.com”再替换一遍。

替换后

替换完成后注意保存。

接着,我们需要将本地的PIP更换镜像源,然后安装所需的包(这里我选用的是阿里源,在全国范围内速度都较快)。

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/

pip install -r requirements_versions.txt //执行此条命令前,请检查你的剩余磁盘空间

pip install xformer //如果不执行此条命令,启动Stable Diffusion时可能会出现错误。xformer还可以在后续使用中降低显卡占用。

由于Stable Diffusion+WebUI使用的是Venv虚拟Python环境,完成上述操作后,我们还需更改Venv目录里的一个配置文件,以让Venv能使用环境外的第三方库。

cd .\venv

code .\pyvenv.cfg

将“include-system-site-packages = false”改为“include-system-site-packages = true”。

更改完成之后保存并退出。

升级PIP

解决方法:

升级pip命令,可以重新打开一个命令行,运行一次它提示的绿色命令(因为文件夹名称可能不同,所以这条命令因人而异)H:\AI\stable-diffusion-webui\venv\Scripts\python.exe -m pip install --upgrade pip

Step4:下载Stable Diffusion模型

模型相当于Stable Diffusion的核心。在没有模型的情况下,Stable Diffusion是无法启动的。所以,我们需先下载模型。Hugging Face(https://huggingface.co)是学习使用Stable Diffusion的不可或缺的平台。你可以从此网站的Model版块中搜索Stable Diffusion来下载模型。不同的模型有自己的美术风格。如Momoko,这个模型专门用来生成二次元图片。

Stable Diffusion的模型后缀名一般为ckpt。偶尔,模型也会附带VAE(.vae.pt)或配置文件(.yaml)。我们需要把ckpt模型、VAE以及配置文件放在models目录下的Stable-diffusion目录中。

注意:如果一个模型附带配置文件或者VAE,你则需要先把它们的文件名改为相同的文件名,然后再放入目录中,否则这个模型的配置可能无法正确读取,影响图片生成效果。

Step5:配置你的Stable Diffusion WebUI

模型配置完成后,重新回到克隆目录中。

cd D:\stable-diffusion-webui

运行“webui-user.bat”。

.\webui-user.bat

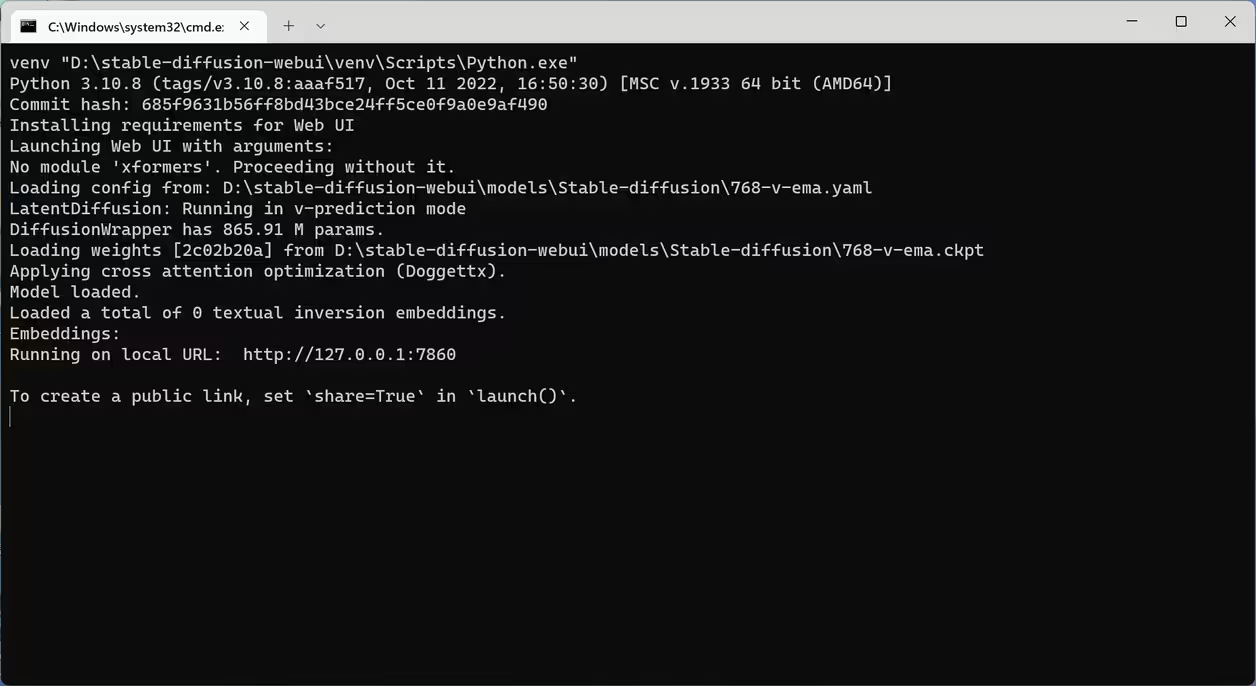

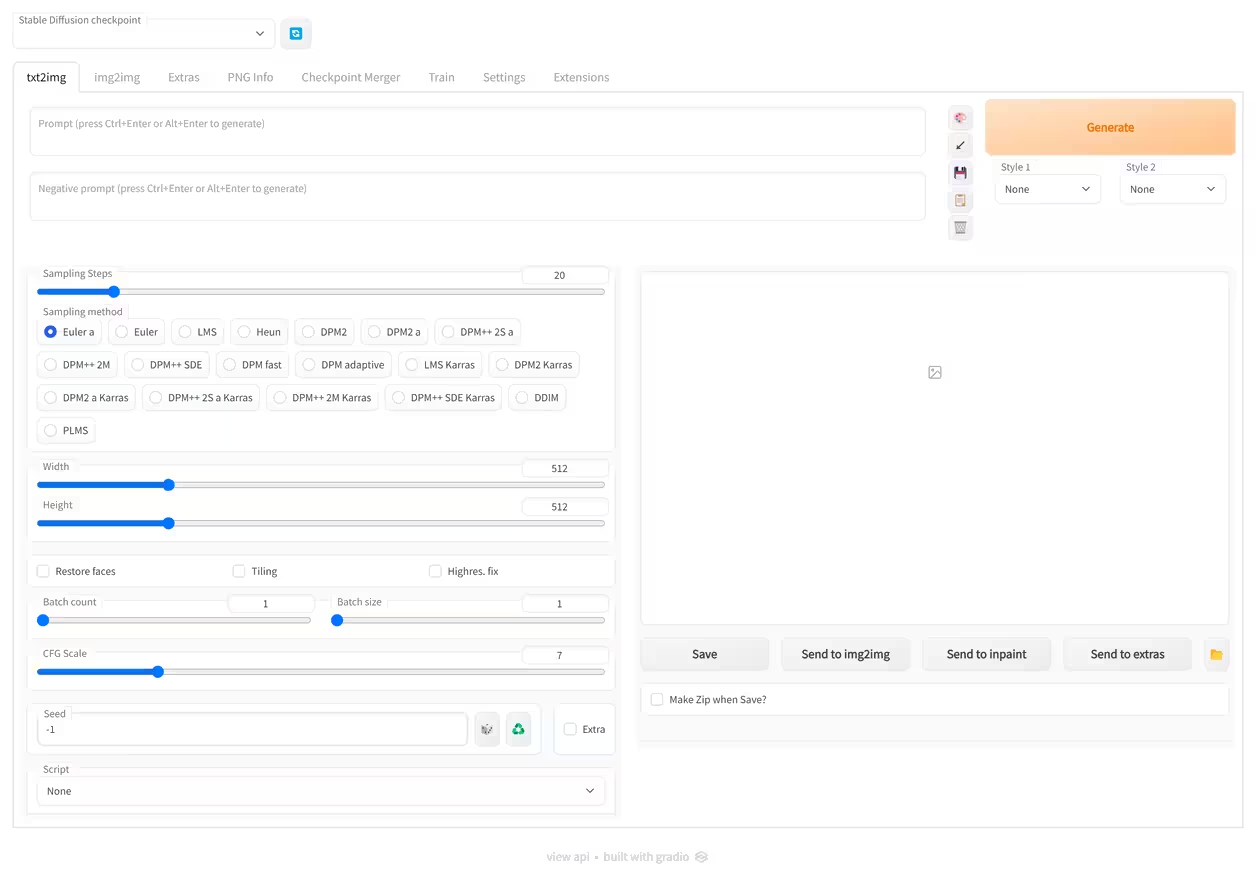

如果你的控制台显示的内容与下图相符,那么恭喜你,Stable Diffusion WebUI的基本框架安装成功了!

控制台

网页

接着,我们会发现WebUI显示的并不是中文。此时,我们需要将其调整为简体中文。这里,我用百度网盘分享了一些语言的补丁。

链接:https://pan.baidu.com/s/1X7R4nQfAxHKdoXRWyknSxg 提取码:annx

下载我分享的“localizations.zip”并解压到克隆文件夹的“localizations”目录中。之后在Settings -> User interface -> Localization (requires restart)设置语言(在下拉菜单中选择zh_CN)。然后重新启动WebUI之后,你就会发现语言变成了简体中文。

如果你愿意,还可以安装一些扩展来实现其它功能。

Step6:使用Stable Diffusion2.0与2.1

Stable Diffusion2.0和2.1是两个刚刚发布的新版本。它们都有自己的专属模型。下面是它们的下载地址与介绍。

Stable Diffusion 2.0:

768-v-ema.ckpt与768-v-ema.yaml(需要改名):这是Stable Diffusion2.0的官方模型,相同的环境下,生成768x768分辨率的图片的速度几乎和1.5版生成512x512图片的速度相同,质量更好。

注:Stable Diffusion2.0还有更多模型,可以自行在Hugging Face上搜索。它们使用同一配置文件,模型放到目录后,只用复制一份配置文件,更改文件名即可。不用重复下载。

Stable Diffusion 2.1

v2-1_512-ema-pruned.ckpt:这是Stable Diffusion2.1的官方模型,可以看作是Stable Diffuison2.0模型的升级版本。它和Stable Diffusion2.0的模型使用同一配置文件。

下载地址:

768-v-ema.ckpt:https://huggingface.co/stabilityai/stable-diffusion-2/resolve/main/768-v-ema.ckpt

768-v-ema.yaml:https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference.yaml(需要改名为768-v-ema.yaml)

v2-1_512-ema-pruned.ckpt:https://huggingface.co/stabilityai/stable-diffusion-2-1-base/resolve/main/v2-1_512-ema-pruned.ckpt

使用这些模型的方法和我前面介绍的方法一样,但镜像源不在国内,故需要用加速器下载。这一点我在前面有提到。只是我在读取Stable Diffusion2.0模型时,WebUI下载了一个3GB多的文件,也不知道是干什么用的。

附加2:学习Stable Diffusion

Bilibili上的元素同典是学习Stable Diffusion的一个不错的平台。在这个平台上,你将会学会Stable Diffusion的各种知识。例如描述词和反描述词。要生成好的图片,除了要有好的模型,还要掌握一些技巧和知识。

如果你也喜欢二次元,Black Lily可能很适合你。它是一个不错的描述词获取源。